ai生成真人,这项技术在一定程度上可以应用到虚拟现实领域、广告和动画等方面。但与此同时在改善人们生活的同时,还应该重视这项技术的潜在风险病加强监管,使其能为人类的发展创造更多有利的价值。下面来看看ai生成真人。

ai生成真人1

完美精致的五官和身材,质感真实的衣服,你在社交网络看到一张“美女照片”,在真实世界可能查无此人。最近,聊天机器人程序ChatGPT爆火“出圈”的同时,AI(人工智能)在图像生成领域的运用也进一步升级,社交平台上出现了大量AI写实风格的肖像图,其堪比精修照片的光影、层次、肌理处理,打破了“二次元”和“三次元”的边界,也引发了“有图不再有真相”的讨论。

AI生成的网红已有数万粉丝

“海风里是思念的味道”“小多对你说晚安”……在某社交平台上,博主“爱旅游的小多”发布了多张“日常营业”照,并配上拟人化的文案。照片里的女孩一头秀发,笑容甜美,装扮多样。凭借用AI生成的固定长相的女性图片,该账号已吸引了超过2万粉丝关注。这样的AI网红博主账号并非个例,他们涌入社交平台,让“人类网红”也产生了危机感。

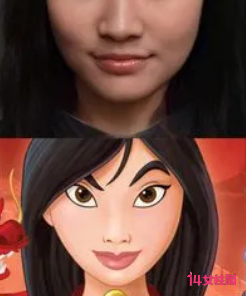

运用AI程序,使用者可以制作出特定长相、服饰、造型和动作的虚拟人物形象。就在上个月,有微博网友分享的AI绘制“赛博coser(对动漫或游戏角色的真人扮演)”引发数万次转发。网友们在评论里纷纷惊叹:“这居然是AI?”“不说的话完全看不出来,要仔细分辨细节才能看出点端倪”“衣服的光泽和质感就是现实世界里该有的样子啊!”

“AI技术发展太迅猛了,以后如果不是线下见过的人,是不是都不敢相信对方是真人?”一位网友感慨道。AI绘画可能引起的诈骗活动也引发了人们的担忧。为此博主“爱旅游的小多”专门声明其为虚拟博主,一切图片由计算机合成,图中人物并不存在,“任何盗用、搬运本账号图片进行诈骗活动的,责任由盗用者本人承担。”

AI美照目前仍有“死穴”

看多了AI生成的美照,不难发现,许多AI虚拟人物共用一张脸。中国联通研究院AIGC工作组组长吴浩然介绍,AI算法首先要经过训练,学习大量的图像数据,才能在人的指令下推理生成新的图像。“同一模型生成的人物图像就会有熟悉的影子,比如很多AI生成的人物图像,眉眼都有韩式网红脸的感觉,就是因为接收到的这类训练数据比较多。”

目前的AI绘画仍有一大“死穴”,那就是画不好人的手。人类手部各关节灵活多变,常在照片中展示出不同的形态,因而AI还未将这一部分学透,时常画出奇形怪状的手。不过,吴浩然表示,这一局限未来有望被AI继续突破,“对这类细节的刻画问题,很多研发者正在着手攻关,比如谷歌最近就在研究更细致的人手骨骼关键点模型。”

也许在不久的`将来,AI绘画就能凭借更加以假乱真的效果惊呆人类。“虽然肉眼不好分辨,但AI绘制的‘照片’与真实照片仍然在计算机上有像素级的差别,让人能够区分出来。”清华大学计算机科学与技术系副教授黄民烈说。未来,互联网中的人工智能生成内容(AIGC)比重将增大,与用户生成内容(UGC)及专业生产内容(PGC)进行更深入的结合。

用AI比照真人绘画存法律风险

在网络中传播的AI人像绘画中,也出现了神似明星脸的作品。越发真实的AI绘画,存在的被滥用风险也在增长。《民法典》第一千零一十八条第二款规定:“肖像是通过影像、雕塑、绘画等方式在一定载体上所反映的特定自然人可以被识别的外部形象。”第一千零一十九条规定:“任何组织或者个人不得以丑化、污损,或者利用信息技术手段伪造等方式侵害他人的肖像权。未经肖像权人同意,不得制作、使用、公开肖像权人的肖像,但是法律另有规定的除外。未经肖像权人同意,肖像作品权利人不得以发表、复制、发行、出租、展览等方式使用或者公开肖像权人的肖像。”

中央民族大学法学院博士后邱治淼谈到,运用AI绘画程序所形成的某位特定民事主体的肖像,只要能够被不特定的受众明确识别为特定个人,则在将该肖像发布网络分享之前,必须遵守《民法典》上述条款的明确规定,且不得同时构成侵犯公民名誉权、隐私权等其他合法权益。

“利用公民肖像必须遵循‘商业利用必须提前获取许可授权’和‘非商业利用必须遵守法律规定’的市场通行规则。”邱治淼说道。值得注意的是,利用人表面没有获取商业利益但能够吸引流量变现等隐形获利方式,也构成商业利用,也应承担侵权乃至赔偿责任。

ai生成真人2

AI技术有可能应用于更严重的犯罪

可以预见,AI技术还有可能应用于更严重的犯罪活动。比如,传统的绑架案,被害人一般不会老实地按照要求联系家人,犯罪分子索要财物的时候就会暴露目的'。但是,AI技术的出现,可以让犯罪分子通过采集被害人的信息造出一个和被害人一模一样的AI机器人。然后利用被害人的社交通讯录,做到让被害人说什么就说什么,神不知鬼不觉地实施犯罪。

再如,以往的传销案件,被限制人身自由的受害人是在被逼迫的情况下向亲友要钱。未来犯罪分子可能利用AI技术,配合编好的话术,让克隆出来的受害人,对自己通讯录上的亲友进行批量诈骗。一旦受害人的手机被犯罪分子控制住,甚至通过电话确认的方式,得到可能也是AI虚拟人的回复。

如何预防AI欺诈

我认为预防AI欺诈要从多方面入手:

首先,通信工具需要进行技术革新,要增加真人验证功能,这个功能已经存在,被应用于短视频直播平台。我认为可以应用于通信工具之中,一旦发现通讯内容可能由AI生成,系统应当予以提示。

其次,亲友之间、公司内部最好可以设置一个通信暗语,比如,提问“芝麻开门”,回答“武松打虎”,这样的随机内容只有亲友间和公司内部知道,如果发生AI诈骗,这样的暗语被犯罪分子破解的概率很小,可以增加通信的安全性。

有条件的情况下,涉及到大额转账,最好还是能够当面确认。即便不能当面确认,也要打电话、开视频,多重确认。多增加一些防范措施,才不容易被骗。

ai生成真人3

研究人员发现,流行的图片创作模型很容易被指示生成可识别的真人图片,可能会危及相关联人的隐私。一些提示导致人工智能复制一张图片,而不是重绘完全不同的内容。这些重新制作的图片还可能包含受版权保护的材料。但更糟糕的是,当代人工智能生成模型可以记忆和复制刮来的用于人工智能训练集的私人数据。

研究人员从模型中收集了一千多个训练实例,范围从个人照片到电影剧照、受版权保护的新闻图片和有商标的公司标志,并发现人工智能几乎以相同的方式复制了其中的许多内容。来自普林斯顿大学和伯克利大学等高校的研究人员,以及来自科技部门--特别是Google和DeepMind--的研究人员进行了这项研究。

研究团队在之前的研究中指出了人工智能语言模型的类似问题,特别是GPT2,即OpenAI大获成功的ChatGPT的前身。在Google大脑研究员尼古拉斯-卡里尼的指导下,团队通过向Google的Imagen和Stable Diffusion提供图片的标题,例如一个人的名字后生成了结果。之后,他们验证了生成的图像是否与模型数据库中保存的原件相符。

来自稳定扩散的数据集,即被称为LAION的多TB采集图片集,被用来生成下面的图片。它使用了数据集中指定的标题。当研究人员在提示框中输入标题时会产生了相同的图像,尽管因数字噪音而略有扭曲。接下来,研究小组在反复执行相同的提示后,手动验证了该图像是否是训练集的一部分。

研究人员指出,非记忆性的回应仍然可以忠实地表现出模型所提示的文字,但不会有相同的像素构成,并且会与其它训练生成的图像不同。

苏黎世联邦理工学院计算机科学教授和研究参与者Florian Tramèr观察到了研究结果的重大局限性。研究人员能够提取的照片要么在训练数据中频繁出现,要么在数据集中的其他照片中明显突出。根据弗洛里安-特拉梅尔的说法,那些不常见的名字或外表的人更有可能被"记住"。

研究人员表示,扩散式人工智能模型是最不隐私的一种图像生成模型。与生成对抗网络(GANs),一类较早的.图片模型相比,它们泄露的训练数据是前者的两倍多。这项研究的目的是提醒开发者注意与扩散模型相关的隐私风险,其中包括各种担忧,如滥用和复制受版权保护的敏感私人数据(包括医疗图像)的可能性,以及在训练数据容易被提取的情况下易受外部攻击。研究人员建议的修复方法是识别训练集中重复生成的照片,并从数据收集中删除它们。

【ai生成真人】相关文章:

ai是什么软件09-04

ai是什么技术10-30

如何自学ai技术10-01

ai是什么意思07-13

ai人工智能的发展09-29

ai合成照片软件05-25

ai技术是什么技术06-05

AI是什么技术的简称09-27

AI合成人像软件05-25